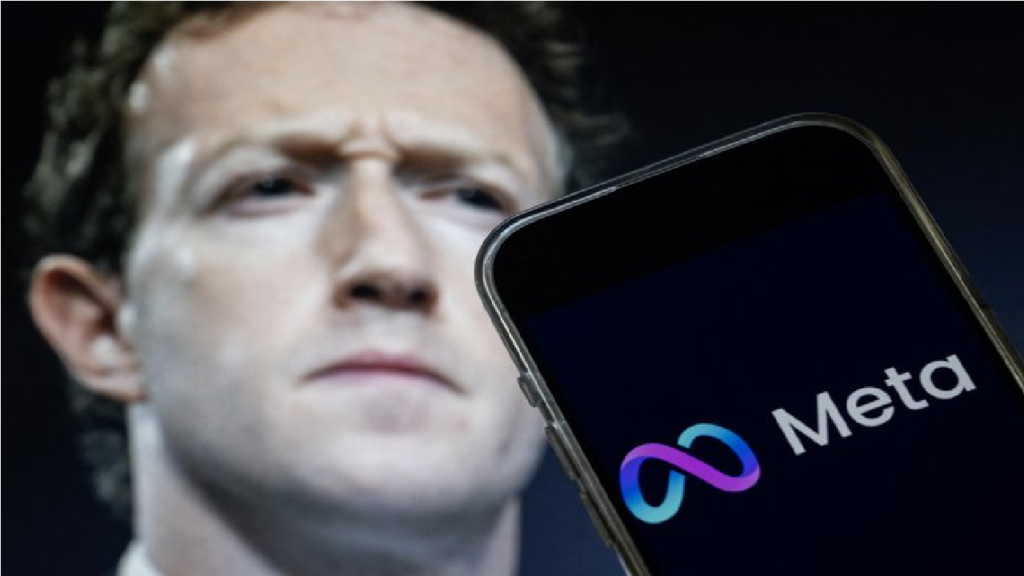

Meta, dona do Facebook, encerra programa de diversidade após encerrar checagem de fatos.

Após anunciar mudanças e o encerramento da checagem de fatos de suas redes sociais nos Estados Unidos, a Meta, de Mark Zuckerberg agora está encerrando seus programas de diversidade, equidade e inclusão (DEI). Segundo a empresa, o movimento é motivado pelo “cenário legal e político em torno dos esforços de diversidade” nos EUA.

Com isso, Meta não terá mais vagas focadas em diversidade, sejam elas voltadas para pessoas negras, mulheres ou para a comunidade LGBTQIA+. A informação foi revelada em um memorando para funcionários internos obtido pelo site Axios.

Segundo o documento, a empresa diz que pretende continuar seus esforços de diversidade, no entanto de outras formas e que vai substituir os programas por modelos que “mitiguem o preconceito para todos, não importa sua origem”.

Em nota, a empresa explica que a decisão é motivada pela Suprema Corte dos Estados Unidos, que recentemente sinalizou proibições para esse tipo de medida em empresas.

“A Suprema Corte dos Estados Unidos recentemente tomou decisões sinalizando uma mudança em como os tribunais abordarão DEI”, escreveu Janelle Gale, vice-presidente de recursos humanos da Meta, segundo a Axios.

O chefe de direitos civis da Meta, Roy Austin, contratado em 2021 em meio aos esforços da empresa para ampliar suas medidas de diversidade, deixou a companhia nesta sexta-feira (10).

Apesar de não ter divulgado oficialmente o memorando, a Meta confirmou o encerramento dos programas e a saída de Austin da empresa.

Meta encerrou programa de checagem de fatos nos EUA

A Meta anunciou que irá acabar com o programa de checagem de fatos e que, no lugar, irá seguir o modelo de Notas de Comunidade, à semelhança do sistema usado pelo X (antigo Twitter).

Na visão da empresa, os verificadores de informação apresentavam muitos vieses em suas escolhas para moderação de conteúdo e, por isso, o sistema teria se tornado uma ferramenta de censura.

Segundo anúncio da Meta, as notas de comunidade irão permitir que outros usuários decidam quais postagens podem desinformar e precisam de mais contexto. Os próprios usuários também irão definir o contexto que precisa ser informado.

“Nós pensamos que essa pode ser uma forma melhor de atingir a nossa intenção inicial de fornecer às pessoas informações sobre o que estão vendo – e uma que é menos propensa a viés”, diz o anúncio da big tech.